Добавилось проблем перед началом лета — спасибо Яндексу за это

Погода нынче в Киеве стоит просто таки летняя — солнце шпарит градусов на +27-29, сидя перед монитором и поглядывая краем глаза на улицу возникает только одно желание — пойти куда-то погулять. Все бы ничего, если бы старый добрый (и тупой) Яндекс не «начудил» в очередной раз. Как же дорог мне этот поисковик, без него жить определенно было бы скучнее, а весь рынок seo был бы монотонным и однообразным.

Погода нынче в Киеве стоит просто таки летняя — солнце шпарит градусов на +27-29, сидя перед монитором и поглядывая краем глаза на улицу возникает только одно желание — пойти куда-то погулять. Все бы ничего, если бы старый добрый (и тупой) Яндекс не «начудил» в очередной раз. Как же дорог мне этот поисковик, без него жить определенно было бы скучнее, а весь рынок seo был бы монотонным и однообразным.

Собственно, несколько дней назад я как раз собирался сходить развеяться как совершенно случайно обратил внимание на то, что один и сайтов вывалился из индекса. Печально всегда находить такие вещи, но тут уж ничего не поделаешь, контент там был далеко не идеален. Тем не менее, все же решил проверить остальные свои сайты на предмет нахождения в индексе. Увиденная картина повергла меня в шок:

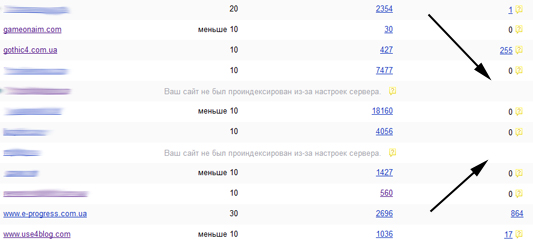

Сразу 10 сайтов вылетели из индекса Яндекса :( Первым делом, я конечно, начал искать причину, так как под удар попал абсолютно нормальный проект «Все про блоги и блоггинг», где писал качественные, авторские статьи и есть постоянная аудитория. Уже в голове прикидывал текст письма Платону с возмущениями как нашел таки некоторую закономерность — все проекты располагались на одном хостинг аккаунте (имели общий IP). Сразу же вспомнил свой печальный опыт 2010 года когда «словил» глюк Яндекса «сайт не проиндексирован из-за настроек сервера«. Добавив все проблемные сайты в панель вебмастера Яндекса понял, что мои опасения верны на 100%:

Из-за настроек сервера, на котором находится сайт, робот Яндекса не мог получить к нему доступ и сайт не был проиндексирован. Уточните у Вашего хостинга не был ли блокирован IP робота ……………… при обращении к сайту.

Хостеру я написал, IP разблокировали, после чего Яндекс пообещал проиндексировать некоторые сайты в течении 1-2 дней или 2 недель. Идет уже третий день, а в индекс, как видите из картинки выше, вернулся менее 1% всех страниц.

Итого имеем в итоге:

- минус 2 сайта в ГГЛ, Ротапост и Миралинксе, где еще придется разбираться с индексацией всех статей со ссылками. Контент уникальный, поэтому, надеюсь, это лишь вопрос времени и денег.

- минус 2 сайта над которыми работал и только-только планировал запустить в Сапу — текст подправил, дизайн улучшил и все напрасно.

- минус 2 сайта в Сапе, которые купил на Telderi и что успели отбить наверное 5% затрат на них =\

Спасибо Яндексу за все это! Странно, что он не выкинул другой мой популярный блог на том же IP. А почему нет, ведь все равно какой возраст проекта, сколько страниц в индексе, качество текстов — главное что робот не смог зайти на сайт и все, прощайтесь со своими проектами, над которыми долго и упорно работали.

Тупости этого подхода я возмущался 2 года назад, не перестаю удивляться и сейчас! Допустим у вас хороший интернет магазин с трафиком из яндекса, заказами и нормальным доходом т.п., а потом в один прекрасный день робот не смог на него попасть и все, прощайтесь с бизнесом. Разве это нормально? Почему никогда такой ереси не бывает у Google, который обрабатывает намного большее число сайтов, у которого задач и проектов не счесть.

Все это, конечно, не «конец света», судя по моему прошлому опыту, но согласитесь ситуация не самая приятная. Почему я жалуюсь на Яндекс, а не хостера? Да потому что последний, в принципе, сделал все логично — заблокировал IP, который слишком сильно «активничал» на аккаунте. А вот действия Яндекса при этом «зарубить сайт на корню» назвать можно бредовыми и неадекватными. Если вы уж сделали свою мега крутую панель вебмастера, то предупреждайте, что робот не может попасть на сайт до того как удалить его из выдачи — это было бы намного полезнее. Кстати, после разброкироваки IP можно было ведь просто вернуть все выпавшие страницы, которые, судя по панели, уже давно загружены. Но нет, Яндекс начал индексировать с нуля. Браво, тут даже женская логика нервно курит в сторонке.

Что дальше? Буду пытаться поскорее вернуть сайты и максимум страниц в индекс Яши, блог потихоньку начал возвращаться, но по 3-5 страниц, что особо не решает проблему. Какие действия можно предпринять в этой ситуации? — я набросал такой небольшой планчик мероприятий:

- Добавление всех сайтов в панель вебмастеров Яндекса дабы следить за ходом событий и удостовериться, что вопрос хотя бы начинает решаться. Сейчас в сообщениях указано, что все проблемные сайты начали индексироваться.

- Создание XML Sitemap на всех сайтах, по желанию можно сделать и обычную карту сайта для людей. После создания карты сайта нужно загрузить в панель вебмастера.

- Добавление robots.txt на сайты, где нужно указать директиву Host и ссылку на sitemap для Яндекса.

- Использование адурирок поисковиков для добавления в индекс некоторых страниц с сайтов — можно ссылки на разделы или последние посты.

- Можно эти же страницы добавить в социальные сети через Sapient InterSocial Submitter.

- Еще есть сервис Letusindex для индексации ссылок — туда загоним по 20-30 последних публикаций + ссылку на RSS. Ну, и еще вроде как есть возможность индексации в Seobudget.

При этом есть смысл загонять в индекс страницы, где у вас продавались ссылки в биржах — ГГЛ, Ротапост, Миралинкс и Сапа. В первых двух точно имеется возможность экспорта соответствующих страниц в файлик, что очень удобно. Хотя, конечно, все эти действия не могут вам ничего гарантировать, учитывая, что работаете вы с Яндексом, а тут — как повезет.

Только посочувствовать могу!

acsession, спасибо, буду потихоньку разгребать этот «подарок» яндекса. Вообще в твиттере встречал и более печальную историю, там сайт возраста 8-10 лет вылетел, еще и клиентский вроде.

Да Яндекс к сожалению кладезь перлов :) но одно дело когда интерес академический, другой когда теряешь деньги на сапе и пр. Сочувствую вообщем.

Уже очень много слышал о Яндексе нехорошего. Конечно очень обидно, что так произошло, сочувствую. Я только учусь всему этому. И у меня вопрос: » Чем и как Вы проверяете индексацию страниц. »

С уважением, СергеЙ.

А на мой взгляд проблема как раз в хостере. Яндекс действует совершенно логично.

Если для его бота сайт не доступен, то, очевидно, он недоступен для всех людей (заблокирован или больше не существует). Если мы оставим его в выдаче, то пользователи будут попадать на несуществующий сайт. А, соответственно, результаты поиска и удовлетворенность пользователей поиском здорово ухудшаться.

А нововведение гугловское Вас не затронуло? То, которое то-ли пингвин то ли еще что за зверь :)

svet1aya, возможно, частично, трафик немного уменьшился, но я особо не проверял конкретные позиции и т.п., у меня нет клиентских сайтов, поэтому мне это сильно не нужно.

Владимир, но ведь хостер никак не мог знать что этот IP это бот яндекса, вдруг это спам, ddos или еще что-то. Кроме того, иногда ведь бывают нештатные ситуации (повышенная нагрузка или форс-мажор) когда возникают проблемы у хостинга и сайт недоступен — что тогда тоже выбрасывать сайт из индекса. С другой стороны, возможно, частично вы правы для результатов поиска хорошо отображать только работающие сайты, я бы на 100% с этим согласился если бы — яндекс также быстро реагировал на возвращение сайта к работе. Робот не смог попасть туда в течении 1-2 дней максимум, а сайта в выдаче нет уже 4-5 дней (хотя все уже доступно)… повезет если за 10 дней что-то изменится. Ладно там мои сайтики, а если это интернет бизнес, магазин, нормально ли потерять доход за 2 недели «из-за робота», доход, который никто не компенсирует, не говоря уже о затратах на продвижения и т.п. Ну, и главный аргумент в пользу вины Яндекса — почему у Гугла таких проблем нет, причем я бы не сказал что у него результаты поиска похуже яши, скорее наоборот.

Сергей, проверяю наличие страниц в индексе Firefox плагином seoquake — быстро и удобно.

С тем, что Яндекс — тормоз, не могу не согласиться. :)

Но логика его работы все равно верная. А по какой причине хостер вообще что-то там блокировал? Если это DDoS, так надо уметь его определять корректно и сообщать клиенту.

Если повышенная нагрузка — то, либо хостинг плохой, либо Ваш сайт его перерос и надо переезжать на что-то более производительное. Если повышенную нагрузку вызывает исключительно бот Яндекса, то скорость индексации можно подрегулировать в Яндекс.Вебмастере.

Да, когда сайт недоступен, его надо убирать из выдачи. Чего неработающему сайту там делать? Откуда Яндексу знать, не будет ли работать сайт 1 день или он умер навсегда?

У нормальных хостеров я редко встречал даунтаймы больше 3-4 часов. И это уже аптайм меньше 99.7%, что не супер совсем.

По собственным косякам бывали даунтаймы и в пару дней, но сайты даже за 2 дня из индекса не вылетали.

Владимир, кстати, вопрос не только к моему хостеру, проблемы были со многими и разными еще в 2009-2010 годах. Опять же о логике — одно дело когда сайт не работает, а другое когда робот не может зайти. Если посмотреть с точки зрения посетителей и «красоты поиска», то решение выкинуть сайт который (внимание) работает, посещаем и доступен и уже пару лет спокойно работает я не могу считат адекватным. Да поисковики это «роботы», но фактически сайт ведь был доступен — почему нельзя проверить его другим роботом с другого ip, почему нельзя написать пользователю уведомлению до того как выкинуть? Поэтому не знаю где тут логика, так как фактически они «убили» из поиска обычные работающие сайты. В общем, я за то что нужно как-то проверять дополнительно, предупреждать и собственно быстро реагировать на исправление ситуации — а то как это делается в Яше просто жуть. С хостером ладно решили вопрос за 5 минут, все разблокировали, а тут — «ждите 2 недели».

Яндекс — частная кампания, которая работает по своим собственным правилам. И если хотите, чтобы Ваш сайт был в индексе, извольте обеспечить доступность сайта 24х7х365. Не можете? Ну а может Ваш сайт и не для людей? :)

На данный момент ситуация такова, что это нам нужен Яндекс, а не мы ему.

Просто у меня есть свои проекты, которые парсят информацию с других сайтов (red-cash.ru, например). Так вот там опрашивается 200 сайтов. И если даже 15 из них недоступны, то мне проще выкинуть их на время из таблицы, чем что-то перепроверять.

Владимир, возвращаемся к тому, что сайт был доступен все это время кроме одного IP (робота). Но вообще, согласен, с позицией что «нам нужен Яндекс, а не мы ему». Понятно, что проще писать стандартные ответы мол «ждите все будет» или «улучшайте сайт» чем уделять каждому много внимания, не эффективно, тут я не спорю. В общем, такое, осадочек остался как 2 года назад, так и сейчас. Поэтому просто надеюсь хоть часть страниц все же вернется в индекс))

Tod, а теперь встаньте на место Яндекса.

С его точки зрения, Вы закрыли сайта для индексирующего бота. Намеренно или по ошибке Яндекс не знает. И после этого обвиняете Яндекс, что он убрал сайт из индекса? :)

Ну это примерно как в robots.txt написать «Disallow: *» и удивляться, что сайт выпал из индекса. :)

Владимир, моя претензия скорее в том, что нужно быть более гибким) Если вы пишите в панели вебмастеров что мол сайт недоступен — то пишите до того как его удалить и индекса. Если все исправилось в течении пары часов, то почему бы также быстро сайт туда не вернуть (тем более что в той же панели указано — страницы загружены уже), а советовать ждать от 2х дней до 2х недель. Если так беспокоитесь о качестве поиска, то проверяйте как-то доступность сайта не только с одного IP робота. Ну, а в целом, конечно, приходится просто подстраиваться под работу поисковых систем будь то Яндекс или Гугл — диктуют правила они и действуют в первую очередь как выгодно/удобно им.

Ситуация неприятная, но если столько сайтов может лучше на VPS их перенести, там хоть этой проблемы не будет. У меня когда-то были проблемы с индексацией Яндекса (в Google все нормально было) после того как хостер каждую ночь начал делал бэкапы по 2-3 часа и сайт был практически недоступен в это время, страницы постоянно вылетали и влетали обратно в индекс. После переезда на виртуальный сервер все нормализовалось, сам решаю когда бэкапить, кого банить и т.д. Надеюсь все у Вас будет хорошо.

что-то я не уловил, почему все считают крайним?

ведь виновен хостинг, который взял и заблокировал бота яндекса, а Яша вообще не приделах

Alex, так в том то и делать что все эти сайты на VPS :) были бы на общем IP думаю другие бы пользователи запаниковали раньше… а так я пока нашел эту ошибку.

barbadoss, не все так считают, скорее это мое личное субъективно мнение… и дело даже не в вине, основная претензия в последнем моем комментарии, надо быть более гибким, думаю.

Этот блог тоже выпал из индекса Яши из-за хостера или тут другая причина?

Нелегал, вот ведь очередной сюрприз от Яши:) А кто-то мне выше говорил что хостер виноват и т.п., ребята разблокировали IP робота за 15 минут, прошла неделя и в панели начали появляться сообщения мол доступ у робота есть, началась индексация, пошла вторая неделя — вылетает еще один сайт… красота! В поддержке спустя 4 дня пообещали разобраться, ну маладцы чо, хорошо работают))

По причинам сказать сложно, в панели написано не было доступа у робота причем «ранее» — когда не уточняется, у других сайтов ранее это 28.04 а потом надпись что доступ появился.. чего выкидывать еще сайт ума не приложу.

Нет, ну «Спасибо Яндексу за все это! » . Я бы все-таки благодарил хостера.

То, что Гугл не выкинул, сами понимаете, что значит у Гугла был доступ, а Яндекса заблочил хостер.

Почему вылетели не все сайты? А вы хотели все? Просто Яндекс немного медленнее Гугла, обходит сайты — обычные бывает раз в месяц заглянет. Поэтому просто одним проектам повезло, другим нет.

Так что я бы мучал хостера и не пенял бы на Яндекса. В некоторых вещах Гугл куда жесче. Например не продлили один сайт — в итоге на завтра же сайт пропадает из индекса Гугла на все 100%. Единственное, как только сайт снова онлайн — пару дней и снова те же позиции. В случае с Яндексом — придеться подождать пару апов… Не все же сразу.

Странно, что Тод как-то вроде должен быть «в теме», но банальных вещей не понимает/принимает.

Если бы действительно всего пару апов… :)

Я с robots.txt накосячил в январе. Недели 2 это было совершенно незаметно. Потом выпало 3/4 страниц. :)

Так в панели вебмастера вижу, что к некоторым страницам последний раз робот обращался 26.01.2012, а сегодня уже 14 мая. Хотя конечно, 90% уже вернулось. А 70% страниц, действительно, вернулись за 2-3 апа. Но, конечно, не за 3 дня. :)

Avdenago, вылетело 8 сайтов, прошла неделя и полетел еще один — этот блог, при том что робота разблокировал сразу же, где логика) из 10-ти остался один, вот думаю он на очереди.

Чем мне мучать хостера? они разблокировали IP робота за 15 минут в тот же день, что мне им еще предъявить) Повторюсь речь идет не о продлении, не о доступности сайта — в это случае можно было бы еще «понять и простить», но когда нормальные работающие сайты по 2 недели вне индекса, ну это тупизм. Подождать пару апов? Ну, действительно что еще остается делать… я это понимаю, но возмущаюсь себе по чуть-чуть:) имею право, т.к. простой 10-20 дней это серьезно. Время — деньги:)

Владимир, я все понимаю, что вернется за 2-3 апа, что Яша пишет подождите и все будет, ну как уже сказал выше, несерьезно все это (ИМХО). Особенно то что при доступном роботе через неделю вылетает еще 1 сайт с того же VPS, а в панели та же отмазка мол «ранее» не было доступа. Не ну это уже не то что нелогично, ненормально вроде как.

В панели вебмастера, кстати, уже некоторые сайты пишет по третьем кругу мол доступ появился, начинаем индексировать сначала 5-го, потом 9-го числа, а в поиске все равно ноль, роботс загрузил, проверил раза 2, сайтмапа тоже есть. Поддержка ответила — простите что так вышло, будем разбираться:)

Страницы же не появляются в индексе сразу после индексации. :)

Вот бот сейчас напылесосит, сколько успеет, и в следующий ап, они появятся в выдаче.

Владимир, судя по информации из панели вебмастера, загружены роботом страницы все, в поиске — ноль. Кстати за это время они иногда появлялись в поиске 5-10-17 страниц, а потом опять ноль. По поводу апов, ждем-с, но если вчера (судя по Серчу) начался какой-то там ап и сразу выпал очередной сайт, то лучше от этих пока не становится:) Остается только ждать дальнейшего развития событий и что там посоветует тех.поддержка.

Тод, меняй хостера, раз такие проблемы